In der Sendung „Hart aber Fair“ präsentiert sich die Professorin Dr. Monika Sieverding mit Aussagen, die der Moderator als „pädagogische Interpertation“ von Statistiken bezeichnet. In diesem Beitrag reagiere ich auf nicht haltbare Methodenkritiken.

Prof. Dr. Monika Sieverding

Prof. Dr. Monika Sieverding, Psychologin und Genderforscherin an der Uni Heidelberg, hat in der Sendung Hart aber Fair die Methodik einer Frage der Weihnachtsstudie kritisiert. Ihrer Ansicht nach ist die Frage nach Regelbrüchen nicht valide. Sie schlägt stattdessen eine alternative Messmethode vor. Ihre Vorwürfe und Vorschläge sind methodisch fragwürdig und deuten darauf hin, dass Frau Prof. Sieverding diese Aussagen ohne intensive Auseinandersetzung mit der Studie getroffen hat. Nachdem sich Hart aber Fair von ihrer Interpretation der Impfstatistik distanziert (siehe Abbildung), nehme ich in diesem Beitrag Stellung zur Studienkritik.

Kollegin Sieverding, die an der Uni Heidelberg lehrt und forscht, kritisiert bei der „Bundeswehr Studie“ (Anmerkung: Sie hat wohl übersehen, dass es sich um die Universität der Bundeswehr und nicht um die Bundeswehr handelt, obwohl das auf jeder Folie mindestens einmal steht), die Frage nach Regelbrüchen sei nicht valide, da die Arten von Regeln nicht spezifiziert worden sei (mal ganz unabhängig davon, ob Sie wirklich Validität oder Reliabilität meint; bleiben wir beim Begriff „Aussagekraft“ generell). Ihr Vorschlag ist, man hätte die Probanden zuerst fragen sollen, welche Regeln sie kennen und dann darauf basierend eine Bewertung der Sinnhaftigkeit, gefolgt von zwei Ratingskalen zur Bruchintention.

Konkret hätte sie also Anfang Dezember Menschen gefragt, welche Regeln sie für Weihnachten kennen. Die Tatsache, dass diese konkreten Regeln drei Wochen im Voraus nicht feststehen, scheint dabei unerheblich zu sein. Im Anschluss hätten diese zuerst nach Sinnhaftigkeit bewerten und dann die Bruchwahrscheinlichkeit in Prozent einschätzen lassen. Nun darf sich jeder Leser ein Bild davon machen, wie man eine solche Detaileinschätzung in Bezug auf eine hypothetischen Regel, die drei Wochen in der Zukunft stattfinden könnte, beantworten soll. Man wird schnell zum Entschluss kommen, dass eine solche Frage nicht wirklich hilfreich ist. Natürlich haben wir diese und andere Optionen schon im letzten Jahr durchexerziert, sind dann aber nach Abwägung aller Vor- und Nachteile zum Entschluss gekommen, einen weniger hypothetischen Ansatz zu wählen. Wir fragen die Menschen, ob sie sich vorstellen können, sich an Weihnachten, zumindest teilweise, über Regeln hinwegsetzen zu können – mit mehreren Antwortoptionen, wie z.B. Ja, wenn … (gefolgt von mehreren Optionen wie bspw. dass die Situation als sicher wahrgenommen wird), Nein und einer Alternativkategorie. Wie wir auch immer deklariert haben, handelt es sich dabei nicht um eine Regelbruchprognose sondern um eine Messung der Offenheit/Bereitschaft, sich Regeln zu widersetzen. Das mag umgangssprachlich ähnlich klingen, ist aber theoretisch und methodisch doch unterschiedlich. Validität, was Sieverding anspricht, bedeutet, ganz vereinfacht gesagt, dass ein Messinstrument (also eine Frage im Fragebogen), das misst, was es messen soll. In unserem Fall Offenheit für Regelbrüche und nicht die Prognose echten Verhaltens. Unsere Annahme ist, dass eine solche Einstellung tendenziell zeitlich stabil ist und wir dadurch eine generelle Tendenz messen können, die v.a. im Vergleich zum Vorjahr oder zwischen verschiedenen Personengruppen, aussagekräftig ist. Letztendlich geht es bei Statistiken immer darum, sie im Kontext von anderen Daten zu vergleichen und dann zu interpretieren. Genau das haben wir gemacht und genau so haben wir die Ergebnisse interpretiert und dokumentiert. Daher sind wir verwundert, wieso sie darauf nicht einging.

Natürlich kann es vorkommen, dass Probanden Fragen nicht korrekt oder unterschiedlich verstehen. So etwas findet man üblicherweise in Pre-Tests heraus (weder in unseren Pretest von 2020 noch in dem von 2021 gab es dazu Anmerkungen; wir pretesten jedes Jahr zuerst mit Wissenschaftlern, dann mit Studierenden – inkl. Diskussion – und dann mit echten Probanden). Bei unseren Befragungen haben wir zudem weitere Freitextfelder, in denen Probanden Anmerkungen zur Studie angeben können. Auch dort gab es keine Anmerkungen zu fehlenden Antwortoptionen oder Verständnisproblemen (wohl aber „Beichten“, dass sich einige an Weihnachten nicht um Corona scheren werden). Last but not least: Hätten alle Probanden, wie von Monika Sieverding behauptet, „irgend etwas“ beantwortet, dann hätten wir ein Zufallsmuster in den Antworten. Die Ergebnisse zeigen aber klare Muster und theoretisch plausible Zusammenhängige mit anderen Variablen (bspw. Impfverhalten), was für nomologische Validität spricht und somit die Annahme der Psychologin nicht bestätigt.

Ergebnisse nicht interpretierbar

Monika Sieverding attestierte in der Sendung, dass sie die Ergebnisse nicht interpretieren könne, aus den von ihr genannten Gründen. Ich weise darauf hin, dass – mit den erhobenen Konzepten und Limitationen einer Studie im Hinterkopf – die Ergebnisse durchaus interpretierbar sind. Die Ergebnisse zeigen ein kohärentes Bild, wie Menschen über die Weihnachtsfeiertage mit Corona umgehen zu denken, nämlich „ziemlich locker“: Sei es die Offenheit zu Regelbrüchen, die geringe Bereitschaft, sich häufiger zu testen oder die Intention, das Thema schlichtweg zu verdrängen. Zudem zeigen wir einen Vergleichswert zum Vorjahr: Es wurde nicht besser!

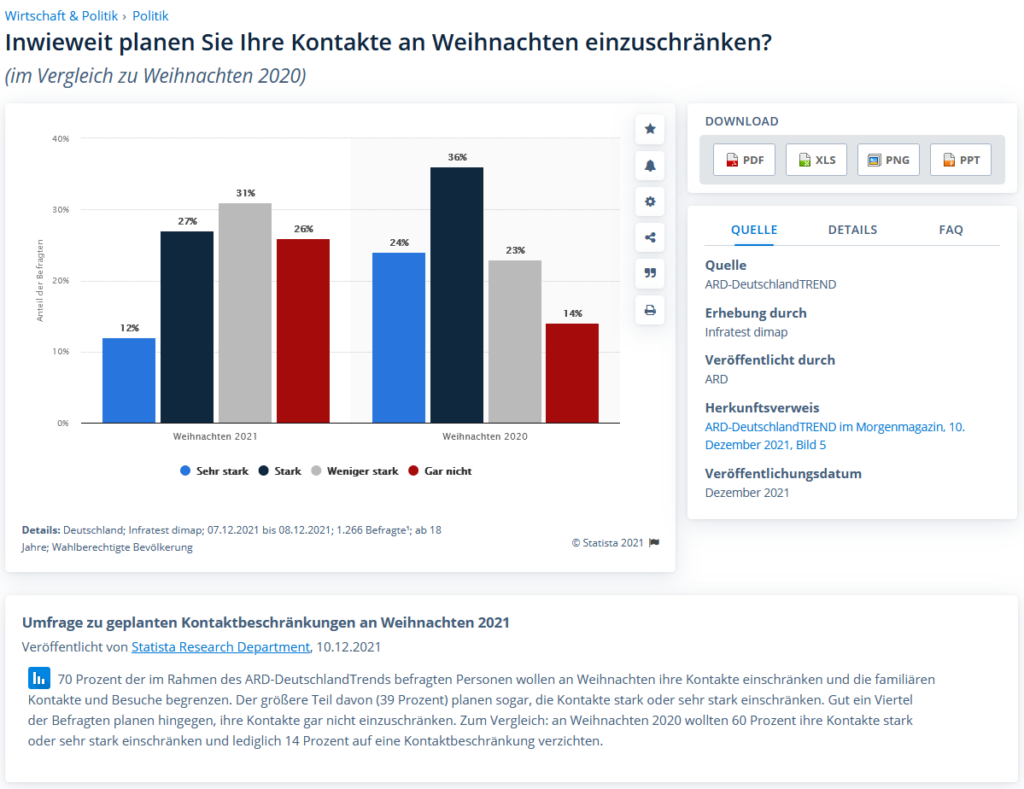

Inwieiwet Ergebnisse generalisierbar sind, lässt sich gut beim Vergleich mit anderen Studien (und idealerweise anderen Methoden) erkennen. Sprich: Kommen andere Studien mit anderen Untersuchungsdesigns zu ähnlichen Schlussfolgerungen? Wenn ja, dann spricht das erstmal grundsätzlich für die Ergebnisse. Unsere Ergebnisse decken sich zudem mit anderen Studien; so hat der ARD Deutschlandtrend bspw. auf die Kontaktreduktion im Dezember 2020 und 2021 abgefragt. Obwohl diese Studie eine sehr ungünstige Skala nutzt (siehe Abbildung), ist auch hier ist deutlich zu erkennen, dass sich Menschen dieses Jahr in Bezug auf Corona „unvernünftiger“ verhalten werden wollen als im Vorjahr.

Insofern ist die Interpretation der Ergebnisse aus meiner Sicht durchaus gegeben.

Unvollständige Darstellung

Es ist auch durchaus interessant, dass Frau Sieverding zwar den Fragetext der Frage in der Sendung wortwörtlich vorlas, nicht aber die Antwortmöglichkeiten. Die Antwortoptionen sind zur Beurteilung einer Methodik mindestens genauso entscheidend, wie der Fragetext. Ob sie es schlichtweg vergessen hat oder bewusst nicht machte, überlasse ich der Interpretation der Lesenden. Die entsprechenden Folien hatte sie jedenfalls ausgedruckt in der Sendung vor sich liegen. Dadurch haben Zuschauer die Vermutung bekommen, wir hätten eine Ja/Nein-Frage gestellt. Das wäre in der Tat kritisch gewesen.

Das Gegenteil war aber der Fall: Wir haben eine Frage mit mehreren Antwortmöglichkeiten gestellt, die sich – aufgrund der oben dargelegten Gründe – nicht auf die Art der Regel, sondern die generellen Motive zur Offenheit von Regelbrüchen beziehen. Zudem gab es eine Ausweichkategorie und eine klare Nein-Antwortoption für all diejenigen, die sich an die Ergebnisse halten wollen. Die Studie kann übrigens über IDW Online eingesehen werden.

Recherche, Fakten und Meinung

Ihre Motivation, die Studie zu kritisieren, mag wohl daran liegen, dass sie den Ergebnissen nicht traut. Frau Prof. Sieverding attestierte nämlich, dass Sie wisse (!), dass sich ein sehr großer Teil der Bevölkerung an die Coronaregeln hält. Quellen oder Studien dazu nennt sie nicht und lassen sich auch in den Forschungsarbeiten, die sie selbst dazu publiziert hat, nicht finden. Ich habe selbst recherchiert und konnte keine ähnlichen Studien finden. Ähnlich argumentiert sie die gesamte Sendung über und ruft dazu auf, die Situation positiver zu sehen und verbiegt dazu selbst die Statistiken der Impfungen (was ihr der Moderator der Sendung vorwirft, wie oben bereits dargelegt). Man darf es durchaus hinterfragen, ob eine solche Aussage in den aktuellen Zeiten angebracht ist.

Ich wurde auch öfters gefragt, wie ich die Daten einschätze – werden X% der Leute etwas machen? Das ist schwierig zu beantworten, da wir nicht prognostizieren. Die Aussage ist lediglich, dass X% der befragten Personen sich zum Zeitpunkt der Erhebung vorstellen können, etwas zu machen. Bei Umfragen – egal welcher Art – gibt es immer die Gefahr der sozialen Erwünschtheit. Das bedeutet: Menschen antworten eher so, wie es sich „gehört“, stellen sich also „besser“ dar. Übertragen auf die Ergebnisse bedeutet das, dass die Daten wohl eher unter- als überschätzt sind.

Wer eine Studie publiziert, muss mit einer kritischen Diskussion rechnen. Nun ist es aber durchaus verwunderlich, dass die Dame einen Kurzbericht als Foliensatz, den sie augenscheinlich nicht vollständig durchgearbeitet hat (Kontext zu anderen Fragen fehlt, falsche Autorenangaben, Fehlinterpretationen u.s.w.), als alleinige Diskussionsgrundlage in einer öffentlichen Fernsehdebatte nutzt. Von einer Wissenschaftlerin würde man, v.a. vor einer öffentlichen Äußerung, durchaus erwarten, dass sie sich intensiver mit der Studie auseinandersetzt – bspw. alle publizierten Ergebnisse aufarbeitet, weitere Berichte anfordert oder mit den Studienautoren in Kontakt tritt. Übrigens: Das Redaktionsteam von Hart aber Fair hatte uns vor der Sendung kontaktiert und wir sprachen ausführlich über die Studie und deren Aussagekraft.

Fazit

Prod. Dr. Monika Sieverding mag zwar mit ihren Aussagen recht haben, dass die Corona-Kommunikation von der Politik und zwischen Menschen nicht optimal ist. Mit meinem Hintergrund in Marketing habe ich auch die Vermutung, dass eine bessere und optimistischere Kommunikation im Sommer dazu hätte führen können, dass weniger Impfskeptiker zu Impfgegnern werden (keine Akzeptanz bedeutet nicht zwangsläufig Resistenz). Keine Studie ist frei von Limitationen und jede Messmethode hat ihre Stärken und Schwächen. Dass eine Wissenschaftlerin aber tatsächlich auf solch eine Art und Weise mit unzureichenden Informationen Studien „zerredet“, ist äußerst fragwürdig. Die Kombination von Fehlinterpretation, guter Rhetorik und einer eingefahrenen Meinung ist eine explosive Mischung, die in der aktuellen Diskussion wohl mehr Schaden als Nutzen bringt. Ich stehe weiterhin hinter den Aussagen der Studie und weise die Methodenkritik der heidelberger Kollegin Monika Sieverding entschieden zurück.

Aber, liebe Frau Sieverding, ich lade Sie recht herzlich zu mir nach München ein. Dann diskutieren wir die Methodenkritik gerne doch detaillierter und tiefgründiger als in diesem Blogbeitrag. Das Angebot ist ernst gemeint und gilt.

Redaktionelle Ergänzungen folgen; Bildquellen: Beitragsbild/Headder: PhotoMIX-Company / pixabay; hartaberfair; statista.